Large language models (LLMs) als ChatGPT zijn populair. Niet alleen voor persoonlijk gebruik, maar ook binnen organisaties. Bedrijfsdocumenten doorzoeken voor specifieke informatie, samenvatten van grote hoeveelheden tekst, of klantdata efficiënter verwerken, zijn een aantal toepassingen van deze modellen waar we gemakkelijk de waarde van kunnen inzien.

Maar kun je LLM’s binnen je organisatie wel zomaar gebruiken? Wat zijn de kosten? En wat gebeurt er met je data? LLMs brengen risico’s met zich mee, maar dat hangt af van vele factoren. Een inkopper is natuurlijk welke LLM je kiest en de configuratie. Dit hangt af van de LLM en de configuratie. In deze blog vertellen we welke LLM typen er zijn, hoe je jouw data veilig kunt gebruiken met deze technologie en geven overzicht zodat je de juiste LLM kan kiezen voor jouw organisatie.

LLM risico's

Voordat we ingaan op de verschillende type LLM’s, bespreken we eerst twee risico’s die wij veel horen bij verschillende organisaties. Wij krijgen vanuit organisaties vaak de vraag over de vertrouwelijkheid van data (voldoet de opslag en het gebruik wel aan de GDPR eisen?) en over schadelijke/ onjuiste output.

- Vertrouwelijkheid van data

Nalatige databescherming kan kostbare consequenties hebben. Een gevolg hiervan is dat gevoelige bedrijfsdata niet meer binnen de eigen muren is opgeslagen en het kan zelfs inzichtelijk worden voor derde partijen. In 2023 hebben we gezien dat deze nalatigheid heeft geleid tot gegevensinbreuken bij meerdere bedrijven, waaronder Samsung. Hierdoor werden cruciale bedrijfsgeheimen gelekt naar OpenAI’s ChatGPT. Dit zorgde er niet alleen voor dat er bedrijfsgeheimen op straat lagen, maar ook de Europese Privacyregelgeving, GDPR (General Data Protection Regulation) werd niet nageleefd.

- Schadelijke/onjuiste output

Onbedoelde schadelijke tekstgeneratie kan een risico vormen bij het gebruik van LLMs. Modellen kunnen, door trainingsdata, onbewust vooringenomenheid en stereotypen bevatten. Dit kan leiden tot de creatie van teksten die beledigend, discriminerend of zelfs haatdragend zijn. Naast ethische bezwaren, kan schadelijke output ook juridische consequenties hebben. Bedrijven kunnen aansprakelijk worden gesteld voor de schade die voortkomt uit teksten die ze genereren of verspreiden.

Deze risico’s kunnen een uitdaging vormen, maar voor alles is een oplossing.

Verschillende typen LLMs

ChatGPT

ChatGPT is de online versie van de LLM-modellen van OpenAI. Het is superhandig omdat je door de gebruiksvriendelijke interface geen techneut hoeft te zijn om de LLM te kunnen gebruiken. Als je ChatGPT gebruikt zonder iets aan te passen in de instellingen, stem je ermee in dat alles wat je invoert wordt opgeslagen op de server van OpenAI. Als je hier je bedrijfsgeheimen deelt dan ben in strijd met de regels van GDPR. Aangezien de gegevens worden opgeslagen in Amerika (OpenAI) in plaats van in Europa. De kosten voor het gebruik van ChatGPT verschilt op basis van hoe je ervoor kiest om het te gebruiken. Je hebt de optie om te betalen op basis van een maandelijks abonnement of per gebruik. Het specifieke tarief hangt af van het type model dat je selecteert en hoe intensief je het gebruikt.

OpenAI API

Een alternatief om OpenAI-modellen te gebruiken, met meer aandacht voor privacy, is het directe gebruik van OpenAI’s Application Programming Interface (API). Hiermee kun je direct met ChatGPT praten, zonder de tussenkomst van een gebruikersinterface (UI). De UI is meer gericht op simpele interactie, maar met de API heb je meer controle, vooral handig voor organisaties die OpenAI-modellen willen inpassen in hun eigen apps. Het model dat de tekst genereert is hetzelfde als bij ChatGPT, maar dan met je eigen interface.

Vanaf 1 maart 2023 heeft OpenAI’s API een upgrade gekregen: ze gebruiken nu geen “prompts” en reacties meer om de modellen te verbeteren. Dat betekent dat je documenten veilig binnenboord blijven, zonder dat er iets naar buiten lekt. En dat is goed nieuws voor de geheimhouding van bedrijfsinformatie. Voor de bescherming van persoonsgegevens biedt OpenAI een belangrijke functionaliteit: je kunt OpenAI vragen de normale algemene voorwaarden aan te passen met hun Gegevensverwerkingsaddendum. Net als bij veel grote Amerikaanse techbedrijven kun je niet je eigen gegevensverwerkings overeenkomst afdwingen en moet je OpenAI’s versie accepteren. Toch is een beschermende gegevensverwerkings overeenkomst een belangrijke eis binnen de GDPR om persoonsgegevens te delen met “verwerkers” zoals OpenAI. De betaalwijze via de API is pay-as-you-go. Met deze betaalwijze betaal je voor iedere oproep.

Azure OpenAI service

Deze Microsoftservice maakt gebruik van een hostingplatform. Een alles-in-één omgeving waarin je applicaties kunt opslaan, beheren en benaderen, terwijl de hele infrastructuur voor je wordt geregeld. Veel organisaties maken al gebruik van Microsoft Azure Cloud platform. En als je kijkt naar de Azure OpenAI service, kun je dezelfde veiligheidsstandaarden verwachten als bij andere Microsoft Azure diensten. Dus ja, je gebruikt hier dezelfde modellen als bij ChatGPT, maar je beheert ze via dat hostingplatform.

Met de Azure OpenAI Service heb je meer controle over de teksten die door OpenAI-modellen worden gegenereerd. Standaard worden de reacties tijdelijk opgeslagen in dezelfde regio als de resource, voor maximaal 30 dagen. Deze data worden gebruikt voor debugging en het onderzoeken van eventueel misbruik van de service. Als je wilt, kun je bij Microsoft aangeven dat je liever niet hebt dat de reacties worden opgeslagen. Als het op gegevensbescherming aankomt, kun je vertrouwen op de standaard gegevensverwerkings overeenkomst, inclusief de standaard contractuele clausules, die door Azure worden geleverd. Ook hier is de betaalwijze pay-as-you-go.

Databricks

Databricks is ook een hostingplatform waar je LLMs kunt opzetten en beheren. Hier heb je een heleboel opties om uit te kiezen, niet alleen van OpenAI, maar ook andere specifieke modellen. Het is een veelzijdige omgeving waarin je je LLM precies kunt finetunen, integreren met data pipelines, en grote implementaties efficiënt kunt verwerken. Dat maakt het perfect voor productieomgevingen die hoge prestaties vereisen. Het is wel technischer dan Azure, dus je hebt wel kennis nodig van data science en data engineering. Dit maakt het minder gebruiksvriendelijk voor de niet-technische gebruiker. Ook Databricks heeft een uitgebreid adequaat data security platform, en voldoet aan de eisen gesteld door de GDPR. Kosten voor het gebruik van LLMs via Databricks liggen over het algemeen hoger dan de alternatieven. Ook hier betaal je op de pay-as-you-go wijze.

Open-source model/eigen LLM

Hier vormen andere modellen de basis van de LLM. Je kan kiezen uit een groot aantal verschillende open-source modellen, bijvoorbeeld op basis van grootte. Het gebruiken van een lokale LLM in plaats van een API-gebaseerde (closed-source) variant geeft je meer controle. Met een lokale LLM worden alle gegevens binnen je eigen organisatie verwerkt, wat het risico op datalekken vermindert. Je hebt dan zelf de touwtjes in handen wat betreft de beveiliging, omdat je de toegang tot het model kunt beheren. Dat helpt om beveiligingsrisico’s te minimaliseren en een op maat gemaakte aanpak te creëren. Je kan dus makkelijker voldoen aan de GDPR-regels omdat je directe invloed hebt op hoe gegevens worden behandeld en opgeslagen.

Deze LLM-toepassing kost het meeste tijd om te realiseren, omdat je de hele infrastructuur moet opzeten. Als je een open-source LLM wilt gebruiken, moet je het hosten op je eigen infrastructuur (on-premise) met krachtige GPU’s en voldoende opslagruimte. Het is belangrijk om hier zorgvuldig naar te kijken en in te investeren, om te voorkomen dat je applicatie ondermaats presteert of traag is. Ook moet je, in tegenstelling tot de genoemde gesloten modellen, zelf meer verantwoordelijkheid nemen voor de output bij open-source modellen. Zowel een voordeel als een nadeel. Je moet niet alleen letten op de nauwkeurigheid van de antwoorden, maar ook op mogelijke aanstootgevendheid. Dit kun je doen door verschillende LLM-technieken toe te passen die als vangrails fungeren. Uiteraard moet je bij de andere LLM’s ook altijd letten op de nauwkeurigheid en zelf blijven nadenken.

Kosten

Zonder goed te kijken naar alle mogelijkheden kunnen de kosten al gauw de pan uit rijzen. Dat is natuurlijk niet de bedoeling, want dan komt de winstgevendheid en haalbaarheid van je project snel in gevaar. Maar maak je geen zorgen, met een zorgvuldige aanpak kan je het beste uit je investering halen!

De kosten van het gebruik van LLMs hangen af van verschillende factoren:

- Modelkeuze: Als je kiest voor geavanceerdere modellen met meer capaciteiten zijn deze modellen vaak duurder. Maar ze zijn dan ook getraind op meer data of kunnen meer data verwerken als input.*

- Gebruiksintensiteit: De frequentie en omvang van het gebruik van de LLM beïnvloeden de kosten. Maar bedenk eens hoeveel voordeel je kan halen uit die gebruiksuren.

- Infrastructuur: De kosten van de infrastructuur die nodig is om de LLM te hosten en te beheren. Je investeert in de optimale prestaties en betrouwbaarheid van je LLM.

Voor verschillende LLM-implementaties zijn verschillende financieringsmethodes beschikbaar:

- Abonnementen: Maandelijkse of jaarlijkse betalingen voor onbeperkt gebruik.

- Pay-as-you-go: Betalen per gegenereerde token of API-aanroep. Meestal betaal je per 1000 tokens, wat ongeveer neerkomt op 750 woorden.**

- On-premise: Implementatie van de LLM op eigen infrastructuur, wat een eerste investering vereist.

We hebben meerdere toepassingen van LLMs met elk hun eigen kenmerken. Afhankelijk van de behoeften kunnen we de perfecte match vinden die voldoen aan de criteria.

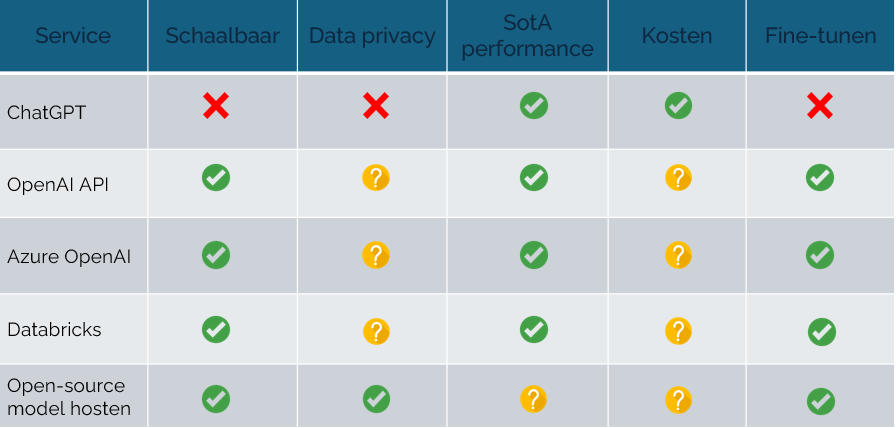

Karakteristieken per service

? Afhangend van instellingen en mate van gebruik

Schaalbaar: Schaalbaarheid betekent dat LLMs flexibel kunnen reageren op allerlei situaties en taken. Ze zijn niet beperkt tot alleen maar wat ze al geleerd hebben, maar kunnen zich ook aanpassen aan nieuwe gegevens en omstandigheden. Dit maakt ze superhandig en veelzijdig voor allerlei specifieke toepassingen.

Data privacy: Data privacy gaat over hoe goed een LLM de privacy van gebruikersgegevens beschermt. Het gaat erom dat persoonlijke informatie veilig wordt bewaard, verwerkt en gedeeld, allemaal volgens de regels van de privacywetgeving.

SotA performance: de “State-of-the-Art”(SotA) betekent dat het model op dat moment wordt beschouwd als het beste wat er is, qua nauwkeurigheid, relevantie en totale prestaties.

Kosten: Dit verwijst naar de kosten die komen kijken bij het gebruik van een LLM, waaronder infrastructuur, productie, onderhoud en eventuele licenties.

Fine-tunen: Fine-tuning betekent dat je de LLM aanpast aan specifieke eisen, gegevens of taken om de prestaties te verbeteren voor een bepaald gebruiksscenario. Je kunt bijvoorbeeld specifieke domeinkennis toevoegen. Door fine-tuning wordt het model nog beter geschikt gemaakt voor bepaalde toepassingen.

Conclusie

Met LLM’s kunnen organisaties efficiënter en innovatiever worden. De keuze van een LLM hangt af van de behoeftes van jouw organisatie. In veel gevallen biedt de Microsoft Azure OpenAI-service een uitstekende oplossing. Het is gebruiksvriendelijk en waarborgt voldoende data security, vooral voor organisaties die al gebruik maken van Azure. Voor meer technische aanpassingen aan je LLM is Databricks een goed alternatief, waarbij data veiligheid ook gewaarborgd is. Als je de volledige controle over dataverwerking wilt behouden, kan het hosten van een open-source LLM op eigen infrastructuur een goede keuze zijn. Op die manier heb je totale controle over het gebruik van je LLM, je data en de output ervan.

Kortom, met de juiste aanpak kunnen LLM’s een waardevolle toevoeging zijn voor elke organisatie. Wil jij specifiek advies voor jouw organisatie? Neem dat contact met ons op en we helpen je graag.

* Om een indicatie te krijgen van de huidige prijzen per token/woord/karakter verwijzen we je naar deze website met een handige reken tool: https://docsbot.ai/tools/gpt-openai-api-pricing-calculator

** Om een indicatie te krijgen van de LLM-performances verwijzen we je naar deze website: https://huggingface.co/spaces/lmsys/chatbot-arena-leaderboard