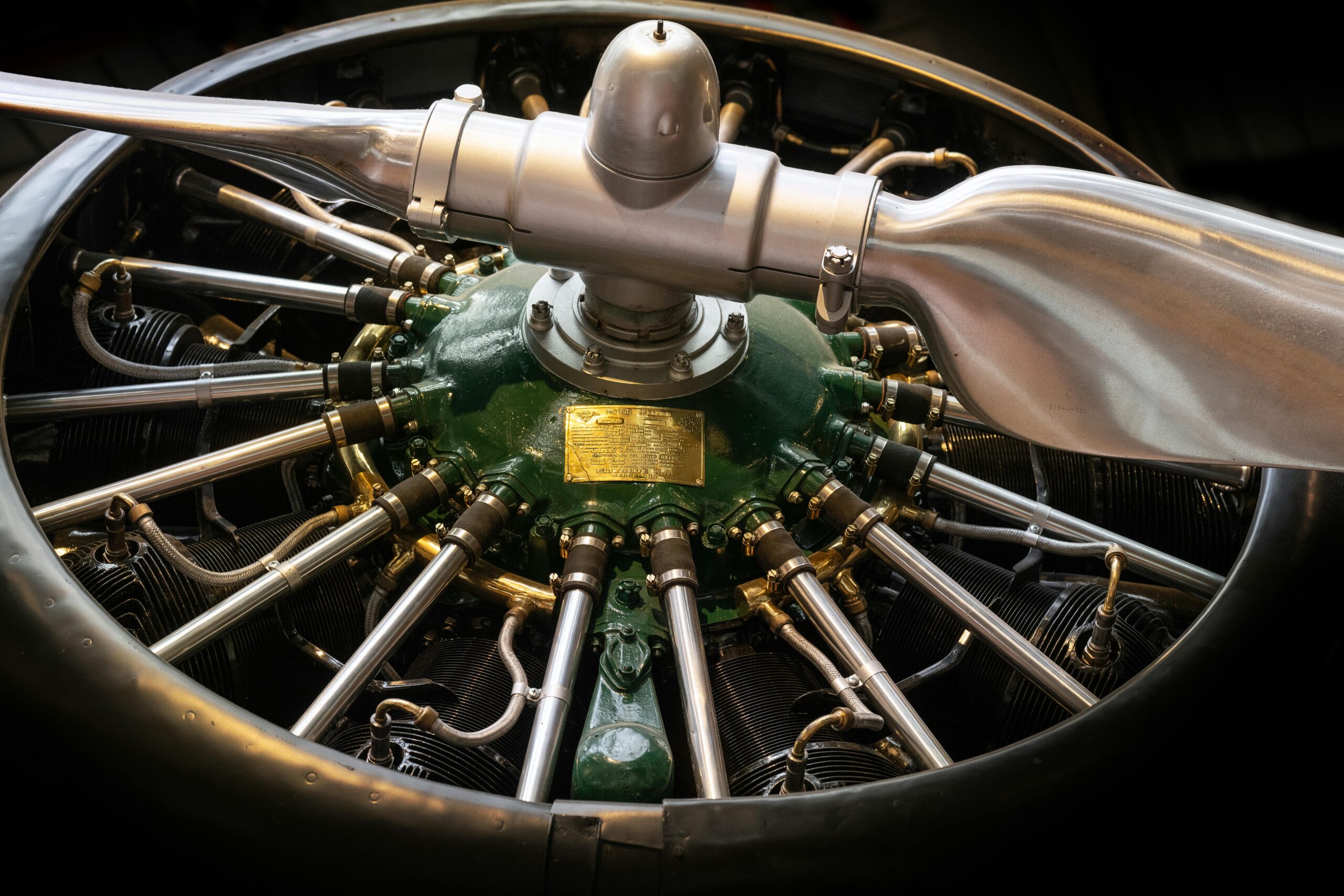

In deze blog legt Tim (Data Engineer) op toegankelijke wijze uit hoe de overstap van pandas naar PySpark eruitziet voor data engineers en data scientists. Hoewel de twee libraries qua syntax overeenkomsten vertonen, zijn er belangrijke conceptuele verschillen. Vooral wanneer het gaat om het verwerken van grote hoeveelheden data via distributed computing.

De werking van Apache Spark, de motor achter PySpark, wordt beschreven en hoe het gebruikmaakt van een driver en executors om data parallel te verwerken. In PySpark werk je met DataFrames die zijn opgedeeld in partitions, wat essentieel is voor schaalbaarheid. Verder behandelt Tim het verschil tussen transformations en actions, het belang van lazy evaluation en waarom bepaalde bewerkingen, zoals wide transformations, veel zwaarder zijn dan andere. Tot slot geeft hij een praktisch voorbeeld van een veelvoorkomende taak in data pipelines: het upserten van data in een bronzetabel met behulp van PySpark binnen Databricks.

Belangrijkste inzichten:

- PySpark is de Python-interface voor Apache Spark.

- Spark is geoptimaliseerd voor big data en maakt gebruik van distributed computing.

- Door lazy evaluation kan Spark de efficiëntste uitvoeringsstrategie bepalen.

- PySpark is ideaal wanneer je data niet meer op één machine past.

👉 Lees het volledige artikel op Medium: Van pandas naar PySpark - Tim Winter